- Che cos'è l'AI Hacking?

- Come viene utilizzata l'intelligenza artificiale per la criminalità informatica?

- Esempi di attacchi informatici all'intelligenza artificiale

- Come l'intelligenza artificiale può essere usata impropriamente per sviluppare malware: Un'analisi degli esperti OPSWAT

- Come difendersi dai cyberattacchi basati sull'intelligenza artificiale

- Domande frequenti (FAQ)

Che cos'è l'AI Hacking?

L'AI hacking è l'uso dell'intelligenza artificiale per migliorare o automatizzare i cyberattacchi. Consente agli attori delle minacce di generare codice, analizzare i sistemi ed eludere le difese con il minimo sforzo manuale.

I modelli di intelligenza artificiale, in particolare i modelli linguistici di grandi dimensioni (LLM), rendono lo sviluppo di attacchi più veloce, più economico e più accessibile agli hacker meno esperti. Il risultato è una nuova serie di attacchi AI più veloci, più scalabili e spesso più difficili da fermare con le difese tradizionali.

Che cos'è un hacker dell'intelligenza artificiale?

Un hacker AI è un attore di minacce che utilizza l'intelligenza artificiale per automatizzare, migliorare o scalare i cyberattacchi. Gli hacker AI utilizzano modelli di apprendimento automatico, AI generativa e agenti autonomi per aggirare i controlli di sicurezza, creare attacchi di phishing altamente convincenti e sfruttare le vulnerabilità del software su scala.

Questi aggressori possono includere sia operatori umani che utilizzano strumenti di IA sia sistemi semi-autonomi che eseguono attività con un input umano minimo. Gli aggressori umani che utilizzano l'IA sono individui del mondo reale - criminali, script kiddies, hacktivisti o attori di Stati nazionali - che utilizzano modelli di IA per potenziare le loro capacità di attacco.

Gli agenti di hacking autonomi sono flussi di lavoro guidati dall'intelligenza artificiale in grado di concatenare compiti come la ricognizione, la generazione di payload e l'evasione, con una supervisione minima. Pur rimanendo guidati da obiettivi definiti dall'uomo, questi agenti possono operare in modo semi-indipendente una volta lanciati, eseguendo attacchi in più fasi in modo più efficiente rispetto agli strumenti manuali.

Come viene utilizzata l'intelligenza artificiale per la criminalità informatica?

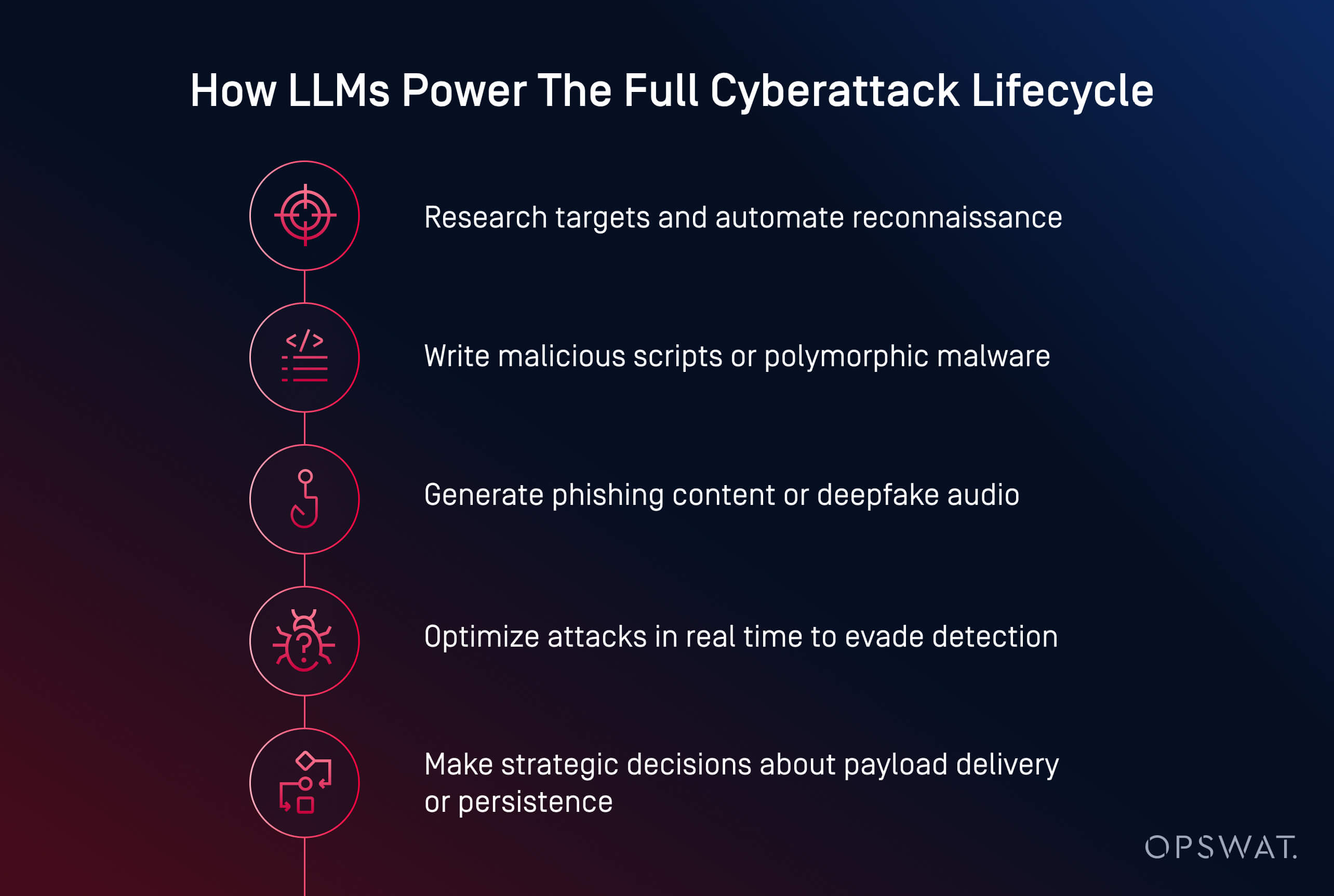

Gli attori delle minacce utilizzano l'intelligenza artificiale per lanciare attacchi informatici più veloci, più intelligenti e più adattivi. Dalla creazione di malware all'automazione del phishing, l'AI sta trasformando la criminalità informatica in un'operazione scalabile. È ora in grado di generare codice dannoso, scrivere contenuti di phishing persuasivi e persino guidare gli aggressori attraverso catene di attacco complete.

I criminali informatici utilizzano l'IA in diverse aree principali:

- Generazione di payload: Strumenti come HackerGPT e WormGPT possono scrivere malware offuscato, automatizzare le tattiche di evasione e convertire gli script in eseguibili. Questi sono esempi di attacchi generativi di intelligenza artificiale, spesso visti nei cyberattacchi con agenti di intelligenza artificiale in cui i modelli prendono decisioni autonome.

- Ingegneria sociale: L'intelligenza artificiale crea e-mail di phishing realistiche, clona voci e genera deepfakes per manipolare le vittime in modo più efficace.

- Ricognizione e pianificazione: L'intelligenza artificiale accelera la ricerca degli obiettivi, la mappatura delle infrastrutture e l'identificazione delle vulnerabilità.

- Automazione su scala: Gli aggressori utilizzano l'intelligenza artificiale per lanciare campagne in più fasi con un input umano minimo.

Secondo il Ponemon Institute, l 'intelligenza artificiale è già stata utilizzata in campagne di ransomware e attacchi di phishing che hanno causato gravi interruzioni operative, tra cui il furto di credenziali e la chiusura forzata di oltre 300 punti vendita durante una violazione del 2023.

Diversi modelli emergenti stanno ridisegnando il panorama delle minacce:

- Democratizzazione dei cyberattacchi: I modelli open-source come LLaMA, ottimizzati per l'offesa, sono ora disponibili a chiunque disponga di una potenza di calcolo locale.

- Riduzione della barriera d'ingresso: Ciò che un tempo richiedeva competenze specialistiche, ora può essere fatto con semplici richieste e pochi clic.

- Maggiore successo di evasione: Il malware generato dall'intelligenza artificiale è in grado di nascondersi meglio dal rilevamento statico, dalle sandbox e persino dall'analisi dinamica.

- Modelli di Malware-as-a-Service (MaaS): I criminali informatici stanno raggruppando le funzionalità di intelligenza artificiale in kit basati su abbonamento, rendendo più facile il lancio di attacchi complessi su scala.

- Uso dell'IA nelle violazioni del mondo reale: Il Ponemon Institute riporta che gli aggressori hanno già utilizzato l'IA per automatizzare il targeting del ransomware, anche in incidenti che hanno forzato l'arresto di importanti operazioni.

Phishing e ingegneria sociale basati sull'intelligenza artificiale

Il phishing e il social engineering abilitati dall'intelligenza artificiale stanno trasformando le truffe tradizionali in attacchi scalabili e personalizzati, più difficili da individuare. Gli attori delle minacce ora utilizzano modelli generativi per creare e-mail credibili, clonare voci e persino produrre videochiamate false per manipolare i loro obiettivi.

A differenza delle truffe tradizionali, le e-mail di phishing generate dall'intelligenza artificiale sono raffinate e convincenti. Strumenti come ChatGPT e WormGPT producono messaggi che imitano le comunicazioni interne, il servizio clienti o gli aggiornamenti delle risorse umane. Se abbinate ai dati violati, queste e-mail diventano personalizzate e hanno maggiori probabilità di successo.

L'intelligenza artificiale alimenta anche nuove forme di ingegneria sociale:

- Gli attacchi di clonazione vocale imitano i dirigenti utilizzando brevi campioni audio per attivare azioni urgenti come i bonifici bancari.

- Gli attacchi deepfake simulano videochiamate o riunioni a distanza per truffe ad alto rischio

In un recente incidente, gli aggressori hanno utilizzato e-mail generate dall'intelligenza artificiale durante un periodo di iscrizione ai benefici, fingendosi addetti alle risorse umane, per rubare le credenziali e ottenere l'accesso ai dati dei dipendenti. Il pericolo risiede nell'illusione della fiducia. Quando un'e-mail ha un aspetto interno, la voce suona familiare e la richiesta sembra urgente, anche il personale esperto può essere ingannato.

Scoperta e sfruttamento delle vulnerabilità da parte dell'intelligenza artificiale

L'intelligenza artificiale sta accelerando il modo in cui gli aggressori trovano e sfruttano le vulnerabilità del software. Ciò che un tempo richiedeva giorni di sondaggi manuali, ora può essere fatto in pochi minuti utilizzando modelli di apprendimento automatico addestrati per la ricognizione e la generazione di exploit.

Gli attori delle minacce utilizzano l'IA per automatizzare la scansione delle vulnerabilità nei sistemi rivolti al pubblico, individuando configurazioni deboli, software obsoleti o CVE non patchati. A differenza degli strumenti tradizionali, l'intelligenza artificiale è in grado di valutare il contesto dell'esposizione per aiutare gli aggressori a dare priorità agli obiettivi di alto valore.

Le tattiche comuni di sfruttamento assistito dall'IA includono:

- Fuzzing automatizzato per scoprire più velocemente le vulnerabilità zero-day

- Generazione di script personalizzati per l'esecuzione di codice in remoto o per il movimento laterale

- Cracking di password e attacchi brute force ottimizzati tramite pattern learning e modelli probabilistici

- Bot di ricognizione che scansionano le reti alla ricerca di asset ad alto rischio con un rumore minimo.

Modelli generativi come LLaMA, Mistral o Gemma possono essere messi a punto per generare payload personalizzati, come shellcode o attacchi di tipo injection, sulla base di caratteristiche specifiche del sistema, spesso aggirando le protezioni integrate nei modelli commerciali.

La tendenza è chiara: l'intelligenza artificiale consente agli aggressori di scoprire e agire sulle vulnerabilità alla velocità delle macchine. Secondo il Ponemon Institute, il 54% dei professionisti della sicurezza informatica considera le vulnerabilità senza patch come la loro principale preoccupazione nell'era degli attacchi basati sull'intelligenza artificiale.

Malware e ransomware guidati dall'intelligenza artificiale

L'ascesa del malware generato dall'intelligenza artificiale significa che le difese tradizionali non sono più sufficienti. Gli aggressori dispongono ora di strumenti che pensano, si adattano ed eludono, spesso più velocemente di quanto i difensori umani possano rispondere.

Il ransomware e il malware polimorfico abilitati dall'intelligenza artificiale stanno ridefinendo il modo in cui si evolvono i cyberattacchi. Invece di scrivere payload statici, gli aggressori ora usano l'intelligenza artificiale per generare malware polimorfo, ovvero codice che cambia costantemente per evitare il rilevamento.

Anche le minacce ransomware si stanno evolvendo. L'intelligenza artificiale può aiutare a scegliere i file da crittografare, analizzare il valore del sistema e determinare il momento ottimale per la detonazione. Questi modelli possono anche automatizzare il geofencing, l'elusione delle sandbox e l'esecuzione in memoria, tecniche tipicamente utilizzate dagli attori delle minacce avanzate.

L'esfiltrazione dei dati con l'intelligenza artificiale si adatta dinamicamente per eludere il rilevamento. Gli algoritmi possono comprimere, crittografare ed estrarre furtivamente i dati analizzando i modelli di traffico, evitando i trigger di rilevamento. Alcuni agenti di malware stanno iniziando a prendere decisioni strategiche: scegliere quando, dove e come esfiltrare i dati in base a ciò che osservano all'interno dell'ambiente compromesso.

Esempi di attacchi informatici all'intelligenza artificiale

I cyberattacchi dell'intelligenza artificiale non sono più teorici: sono già stati utilizzati per rubare dati, aggirare le difese e impersonare gli esseri umani su larga scala.

Gli esempi nelle tre categorie di seguito riportate dimostrano che gli aggressori non hanno più bisogno di competenze avanzate per causare gravi danni negli attacchi informatici. L'intelligenza artificiale abbassa la barriera all'ingresso, aumentando al contempo la velocità, la scala e la furtività degli attacchi. I difensori devono adattarsi testando proattivamente i sistemi integrati nell'IA e implementando protezioni che tengano conto sia della manipolazione tecnica che dell'inganno umano.

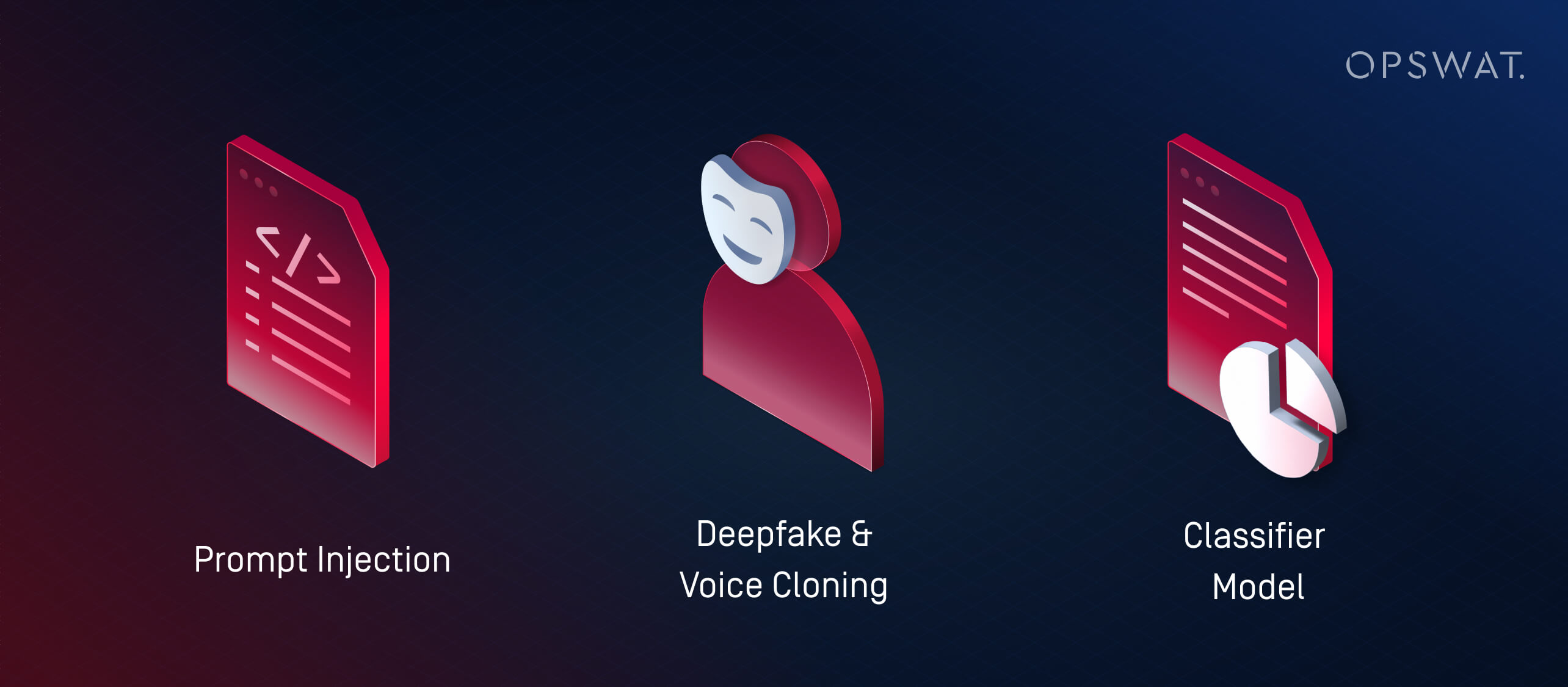

1. Cosa sono gli attacchi di tipo Prompt Injection?

L'iniezione di prompt è una tecnica con cui gli aggressori sfruttano le vulnerabilità degli LLM (modelli linguistici di grandi dimensioni) fornendo loro input appositamente creati per annullare il comportamento previsto. Questi attacchi sfruttano il modo in cui gli LLM interpretano e danno priorità alle istruzioni, spesso senza o con poco malware tradizionale.

Piuttosto che utilizzare l'IA per lanciare attacchi esterni, l'iniezione di prompt trasforma i sistemi di IA di un'organizzazione in agenti inconsapevoli di compromissione. Se un LLM viene incorporato in strumenti come help desk, chatbot o elaboratori di documenti senza adeguate protezioni, un aggressore può inserire comandi nascosti che il modello interpreta e agisce. Questo può portare a:

- Divulgazione di dati privati o riservati

- Esecuzione di azioni non intenzionali (ad esempio, invio di e-mail, alterazione di record).

- Manipolazione dell'output per diffondere disinformazione o innescare azioni successive.

Questi rischi aumentano nei sistemi in cui più modelli passano informazioni tra loro. Ad esempio, un prompt dannoso incorporato in un documento potrebbe influenzare un riassunto dell'intelligenza artificiale, che poi passerebbe informazioni errate ai sistemi a valle.

Con l'integrazione dell'intelligenza artificiale nei flussi di lavoro aziendali, gli aggressori prendono sempre più di mira questi modelli per compromettere la fiducia, estrarre dati o manipolare le decisioni dall'interno.

2. Cosa sono gli attacchi Deepfake e Voice Cloning?

Gli attacchi deepfake utilizzano audio o video generati dall'intelligenza artificiale per impersonare le persone in tempo reale. Abbinati a tattiche di social engineering, questi strumenti vengono utilizzati per frodi, furti di credenziali e accessi non autorizzati ai sistemi.

La clonazione vocale è diventata particolarmente pericolosa. Con pochi secondi di parlato registrato, gli attori delle minacce possono generare un audio che imita il tono, il ritmo e l'inflessione. Queste voci clonate vengono poi utilizzate per:

- Impersonare dirigenti o manager durante le telefonate urgenti

- Ingannare i dipendenti con bonifici bancari o reset di password

- Bypassare i sistemi di autenticazione vocale

I deepfake fanno un ulteriore passo avanti generando video sintetici. Gli attori delle minacce possono simulare un amministratore delegato durante una videochiamata che richiede dati riservati, oppure apparire in clip registrate che "annunciano" cambiamenti di policy che diffondono disinformazione. Il Ponemon Institute ha riportato un caso in cui gli aggressori hanno utilizzato messaggi generati dall'intelligenza artificiale spacciandosi per addetti alle risorse umane durante il periodo di iscrizione ai benefit di un'azienda, con conseguente furto di credenziali.

Con l'aumento dell'accesso agli strumenti di intelligenza artificiale, anche i piccoli attori delle minacce possono generare impersonificazioni ad alta fedeltà. Questi attacchi aggirano i filtri antispam tradizionali o le difese degli endpoint sfruttando la fiducia.

3. Cosa sono gli attacchi ai modelli di classificazione (Adversarial Machine Learning)?

Gli attacchi ai modelli di classificatori manipolano gli input o il comportamento di un sistema di intelligenza artificiale per forzare decisioni errate senza necessariamente scrivere malware o sfruttare il codice. Queste tattiche rientrano nella più ampia categoria dell'apprendimento automatico avverso.

Le strategie principali sono due:

- Attacchi di evasione: L'aggressore crea un input che inganna il classificatore e lo identifica erroneamente, ad esempio un malware che imita file innocui per aggirare i motori antivirus.

- Attacchi di avvelenamento: Un modello viene addestrato o messo a punto su dati deliberatamente distorti, alterando la sua capacità di rilevare le minacce.

I modelli supervisionati spesso "si adattano troppo": apprendono modelli specifici dai dati di addestramento e mancano gli attacchi che si discostano di poco. Gli aggressori sfruttano questo aspetto utilizzando strumenti come WormGPT (un LLM open-source ottimizzato per compiti offensivi) per creare payload appena al di fuori dei limiti di rilevamento noti.

Si tratta della versione machine-learning di un exploit zero-day.

AI Hacking vs. Hacking tradizionale: Differenze chiave

Gli hacker dell'AI utilizzano l'AI per automatizzare, migliorare e scalare i cyberattacchi dell'AI. Al contrario, l'hacking tradizionale richiede spesso scripting manuale, competenze tecniche approfondite e un notevole investimento di tempo. La differenza fondamentale sta nella velocità, nella scalabilità e nell'accessibilità: anche gli attaccanti meno esperti possono ora lanciare sofisticati cyberattacchi basati sull'intelligenza artificiale con pochi comandi e una GPU di livello consumer.

Aspetto | Hacking dell'intelligenza artificiale | Hacking tradizionale |

|---|---|---|

Velocità | Quasi istantaneo con l'automazione | Scripting manuale e più lento |

Requisiti di abilità | Basato su prompt; bassa barriera all'ingresso, ma richiede l'accesso al modello e la sua messa a punto. | Elevato; richiede una profonda competenza tecnica |

Scalabilità | Alto - supporta attacchi in più fasi su più obiettivi | Limitato dal tempo e dallo sforzo umano |

Adattabilità | Dinamico: l'intelligenza artificiale adatta i carichi utili e l'evasione in tempo reale. | Script statici o semi-adattabili |

Vettori di attacco | LLM, deepfakes, attacchi a modelli classificatori, agenti autonomi | Malware, phishing, ricognizione manuale ed exploit |

Avvertenze | Può essere imprevedibile; manca l'intento e il contesto senza la supervisione umana. | Controllo più strategico, ma più lento e manuale |

Uso improprio dell'IA e apprendimento automatico avverso

Non tutte le minacce all'intelligenza artificiale comportano la generazione di malware: alcune prendono di mira gli stessi sistemi di intelligenza artificiale. Le tattiche avversarie di apprendimento automatico, come l'iniezione di prompt e l'avvelenamento dei modelli, possono manipolare i classificatori, aggirare il rilevamento o corrompere il processo decisionale. Poiché l'IA diventa centrale nei flussi di lavoro della sicurezza, questi attacchi evidenziano l'urgente necessità di test robusti e di una supervisione umana.

Come l'intelligenza artificiale può essere usata impropriamente per sviluppare malware: Un'analisi degli esperti OPSWAT

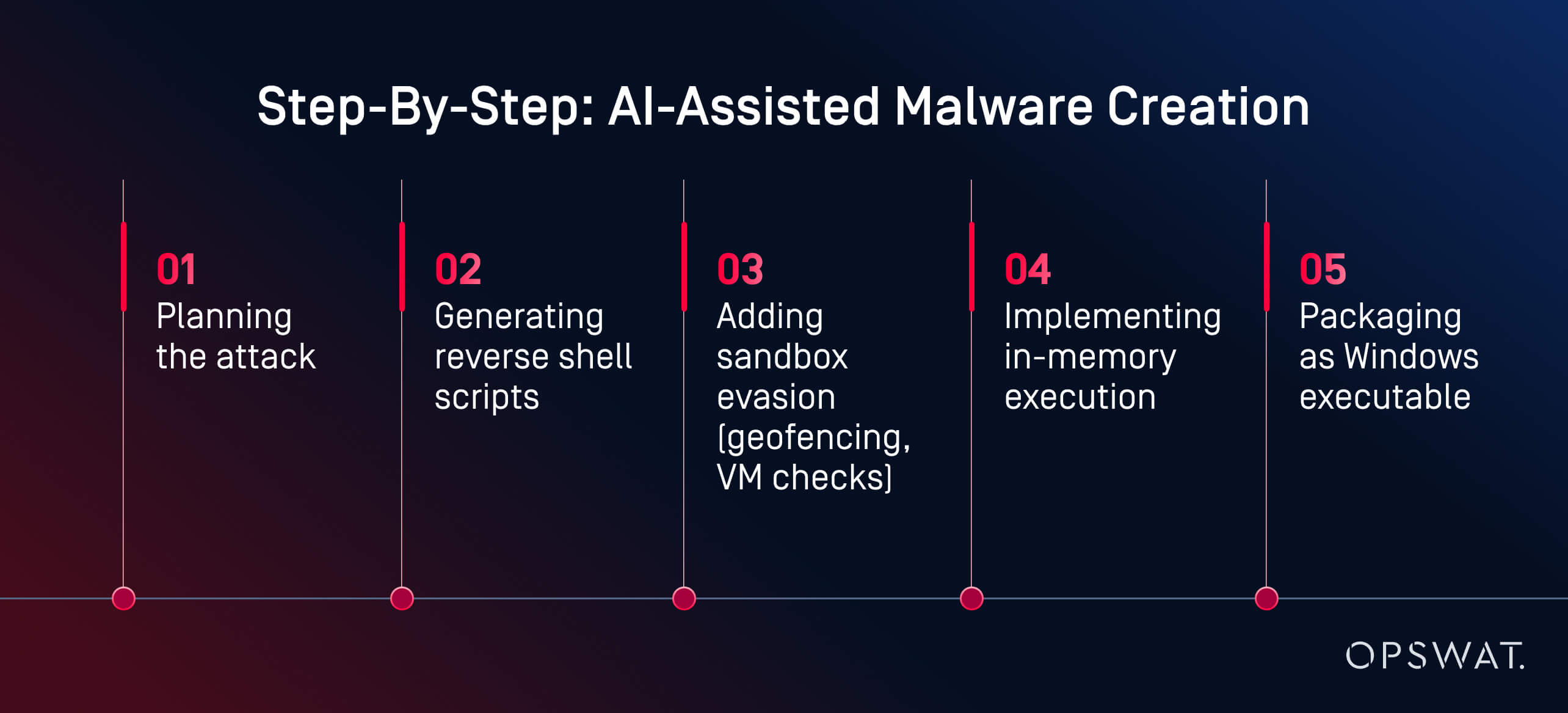

Ciò che un tempo richiedeva competenze avanzate, ora richiede solo richieste e pochi clic.

In un esperimento dal vivo, l'esperto di cybersicurezzaOPSWAT Martin Kallas ha dimostrato come gli strumenti di AI possano essere utilizzati per creare malware evasivo in modo rapido, economico e senza competenze avanzate. Utilizzando HackerGPT, Martin ha costruito un'intera catena di malware in meno di due ore. Il modello lo ha guidato in ogni fase:

"L'intelligenza artificiale mi ha guidato in ogni fase: pianificazione, offuscamento, elusione ed esecuzione", ha spiegato Martin. Il risultato è stato "... un payload generato dall'IA che ha eluso il rilevamento da parte di 60 dei 63 motori antivirus presenti su VirusTotal". Anche l'analisi comportamentale e il sandboxing non sono riusciti a segnalarlo come dannoso.

Non si trattava di uno Stato nazionale. Non si trattava di un hacker black hat. Si trattava di un analista motivato che utilizzava strumenti pubblicamente disponibili su una GPU di livello consumer. Il fattore chiave? Modelli di intelligenza artificiale ospitati localmente e senza restrizioni. Con oltre un milione di modelli open-source disponibili su piattaforme come Hugging Face, gli aggressori possono scegliere da una vasta libreria, perfezionarli per scopi malevoli ed eseguirli senza alcun controllo. A differenza dei servizi basati su cloud, i LLM locali possono essere riprogrammati per ignorare le protezioni ed eseguire operazioni offensive.

"Questo è ciò che può costruire un dilettante motivato. Immaginate cosa potrebbe fare uno Stato nazionale", ha avvertito Martin. Il suo esempio mostra come l'abuso dell'IA possa trasformare il crimine informatico da una professione qualificata a un flusso di lavoro accessibile e assistito dall'IA. Oggi la creazione di malware non è più un collo di bottiglia. Il rilevamento deve evolversi più rapidamente degli strumenti che gli aggressori hanno a portata di mano.

Come difendersi dai cyberattacchi basati sull'intelligenza artificiale

Abbiamo bisogno di una difesa stratificata, non solo di un rilevamento più intelligente.

La difesa dei sistemi dai cyberattacchi alimentati dall'intelligenza artificiale richiede una strategia a più livelli che combini l'automazione con l'intuizione umana e la prevenzione con il rilevamento. Le principali soluzioni di cybersecurity basate sull'AI, come la piattaforma di prevenzione avanzata delle minacce di OPSWAT, integrano prevenzione e rilevamento. Guardate il video per saperne di più.

Test di sicurezza AI e Red Teaming

Molte organizzazioni si rivolgono al red teaming assistito dall'intelligenza artificiale per testare le proprie difese contro l'uso improprio di LLM, l'iniezione di prompt e l'elusione dei classificatori. Queste simulazioni aiutano a scoprire le vulnerabilità dei sistemi integrati nell'IA prima che lo facciano gli aggressori.

I team rossi utilizzano prompt avversari, phishing sintetico e payload generati dall'intelligenza artificiale per valutare se i sistemi sono resilienti o sfruttabili. I test di sicurezza dell'intelligenza artificiale comprendono anche:

- Modelli di fuzzing per i rischi di prompt injection

- Valutazione del modo in cui gli LLM gestiscono gli ingressi manipolati o concatenati

- Verifica della robustezza del classificatore rispetto al comportamento evasivo

I responsabili della sicurezza stanno anche iniziando ad analizzare i propri LLM per individuare eventuali fughe di notizie, allucinazioni o accessi involontari alla logica interna, un passo fondamentale man mano che l'IA generativa viene integrata nei prodotti e nei flussi di lavoro.

Una difesa più intelligente: L'approccio di OPSWAT

Invece di cercare di "combattere l'IA con l'IA" in un ciclo reattivo, Martin Kallas sostiene la necessità di una difesa proattiva a più livelli. Le soluzioni OPSWAT combinano tecnologie che mirano all'intero ciclo di vita delle minacce:

- Metascan™ Multiscanning: Esegue i file attraverso più motori antivirus per rilevare le minacce che non vengono rilevate dai sistemi con un solo motore antivirus.

- MetaDefender Sandbox™: Analizza il comportamento dei file in ambienti isolati, rilevando anche i payload generati dall'intelligenza artificiale che eludono le regole statiche.

- Deep CDR™: Neutralizza le minacce ricostruendo i file in versioni sicure, eliminando gli exploit incorporati.

Questo stack di sicurezza a livelli è progettato per contrastare la natura imprevedibile del malware generato dall'intelligenza artificiale, comprese le minacce polimorfiche, i payload in-memory e le esche deepfake che eludono gli strumenti tradizionali. Poiché ogni livello si rivolge a una fase diversa della catena di attacco, ne basta uno per rilevare o neutralizzare la minaccia e far crollare l'intera operazione prima che possa causare danni.

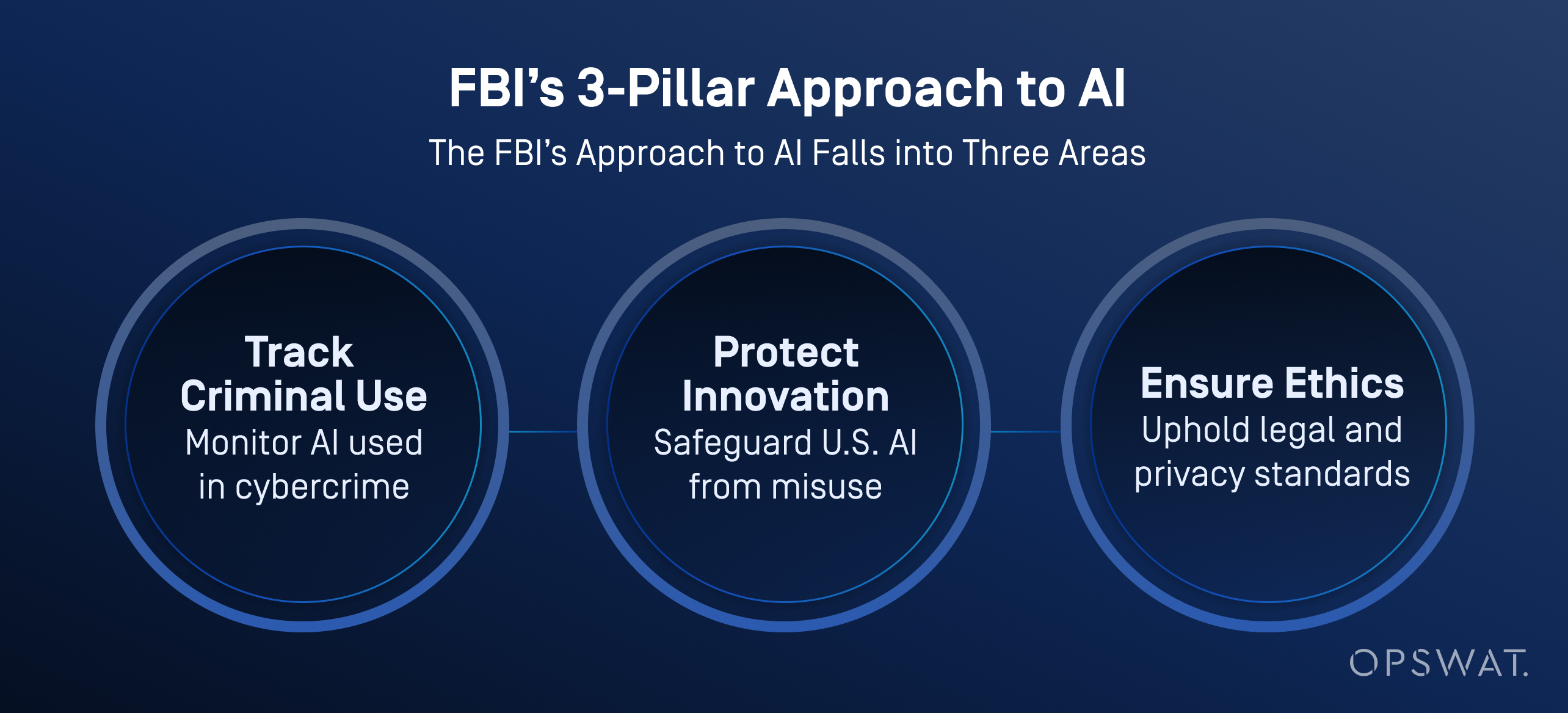

Casi d'uso del settore: Quale intelligenza artificiale utilizza l'FBI?

L'FBI e altre agenzie statunitensi stanno integrando sempre di più l'intelligenza artificiale nelle loro operazioni di difesa informatica non solo per classificare e dare priorità alle minacce, ma anche per migliorare l'analisi dei dati, l'analisi video e il riconoscimento vocale.

Secondo l'FBI, l'IA aiuta a elaborare grandi volumi di dati per generare piste investigative, tra cui il riconoscimento dei veicoli, l'identificazione della lingua e la conversione da parola a testo. È importante notare che l'FBI impone una rigorosa supervisione umana: tutti i risultati generati dall'IA devono essere verificati da investigatori esperti prima di intraprendere qualsiasi azione.

L'IA non sostituisce il processo decisionale umano. L'FBI sottolinea che un essere umano è sempre responsabile dei risultati delle indagini e che l'IA deve essere utilizzata in modo da rispettare la privacy, le libertà civili e gli standard legali.

Le organizzazioni sono pronte?

Nonostante l'aumento delle minacce guidate dall'intelligenza artificiale, solo il 37% dei professionisti della sicurezza dichiara di sentirsi pronto a fermare un attacco informatico basato sull'intelligenza artificiale, come si legge nello State of AI Cybersecurity Report di Ponemon. Molti si affidano ancora a piani di gestione del rischio informatico obsoleti e a strategie di rilevamento reattive.

Il percorso da seguire richiede 4 passi essenziali:

- Adozione più rapida di strumenti di difesa consapevoli dell'intelligenza artificiale

- Red teaming continuo e test di rischio tempestivi

- Uso attivo di Multiscanning, CDR e Sandboxing

- Formazione degli analisti SOC per il lavoro con gli strumenti di indagine automatizzati.

L'intelligenza artificiale ha cambiato le regole. Non si tratta di sostituire gli esseri umani, ma di fornire loro gli strumenti per superare gli attacchi che ora pensano da soli. Scoprite come la nostra piattaforma aiuta a proteggere file, dispositivi e flussi di dati negli ambienti IT e OT.

Domande frequenti (FAQ)

Che cos'è l'AI hacking?

L'AI hacking è l'uso di strumenti come i modelli linguistici di grandi dimensioni (LLM) per automatizzare o migliorare i cyberattacchi. Aiuta gli aggressori a creare malware, lanciare campagne di phishing e aggirare le difese più velocemente e più facilmente di prima.

Come viene utilizzata l'IA per la criminalità informatica?

I criminali utilizzano l'intelligenza artificiale per generare malware, automatizzare il phishing e velocizzare le scansioni delle vulnerabilità. Alcuni strumenti, come quelli venduti sui forum del dark web, possono persino guidare gli aggressori attraverso catene di attacco complete.

Qual è la differenza tra l'AI hacking e l'hacking tradizionale?

L'hacking tradizionale richiede un'attività pratica di codifica, l'utilizzo di strumenti e competenze tecniche. L'AI hacking riduce questa barriera con modelli che generano payload, script e contenuti di phishing da semplici richieste. Queste tecniche rendono gli attacchi più veloci, scalabili e accessibili ai dilettanti.

In che modo l'intelligenza artificiale può essere utilizzata per sviluppare malware?

L'intelligenza artificiale è in grado di generare malware polimorfo, shell inverse e payload invasivi per le sandbox con pochi input. Come mostrato in una demo live di OPSWAT , un utente non malintenzionato ha creato un malware quasi zero-day in meno di due ore utilizzando modelli di IA open-source in esecuzione su un PC da gioco.

L'intelligenza artificiale può sostituire gli hacker?

Non ancora, ma può gestire molti compiti tecnici. Gli hacker scelgono ancora obiettivi e bersagli, mentre l'intelligenza artificiale scrive codice, elude il rilevamento e adatta gli attacchi. Il vero rischio sono gli aggressori umani amplificati dalla velocità dell'IA.

Che cos'è un hacker dell'intelligenza artificiale?

Un hacker AI è una persona o un sistema semi-autonomo che utilizza l'AI per lanciare attacchi informatici, automatizzare malware o eseguire campagne di phishing su scala.

Quale intelligenza artificiale utilizza l'FBI?

L'FBI utilizza l'intelligenza artificiale per il triage delle minacce, l'analisi forense, il rilevamento delle anomalie e l'elaborazione delle prove digitali. Questi strumenti aiutano ad automatizzare le indagini e a far emergere i casi ad alta priorità, riducendo al contempo il carico di lavoro degli analisti.

Qual è un esempio di attacco AI?

Un caso reale ha riguardato le e-mail di phishing generate dall'intelligenza artificiale durante il periodo di iscrizione ai benefit di un'azienda. Gli aggressori hanno impersonato le risorse umane per rubare le credenziali. In un altro caso, l'intelligenza artificiale ha contribuito ad automatizzare il targeting del ransomware, costringendo un marchio multinazionale a chiudere le operazioni.

Cosa sono i cyberattacchi dell'intelligenza artificiale?

I cyberattacchi AI sono minacce sviluppate o eseguite con l'aiuto dell'intelligenza artificiale. Ne sono un esempio il phishing generato dall'intelligenza artificiale, le impersonificazioni di deepfake, l'iniezione di prompt e l'elusione dei classificatori. Questi attacchi spesso eludono le difese tradizionali.

In che modo gli hacker e i truffatori utilizzano l'intelligenza artificiale per colpire le persone?

Gli hacker utilizzano l'intelligenza artificiale per personalizzare le e-mail di phishing, clonare le voci per le truffe telefoniche e generare video deepfake per ingannare gli obiettivi. Queste tattiche sfruttano la fiducia dell'uomo e rendono vulnerabili all'inganno realistico creato dall'intelligenza artificiale anche utenti ben addestrati.

Come posso difendermi dagli attacchi basati sull'intelligenza artificiale?

Utilizzare una difesa a più livelli: Multiscanning, sandboxing, CDR e red teaming guidato da umani. Gli attacchi dell'intelligenza artificiale si muovono velocemente. I difensori hanno bisogno di automazione, contesto e velocità per tenere il passo.